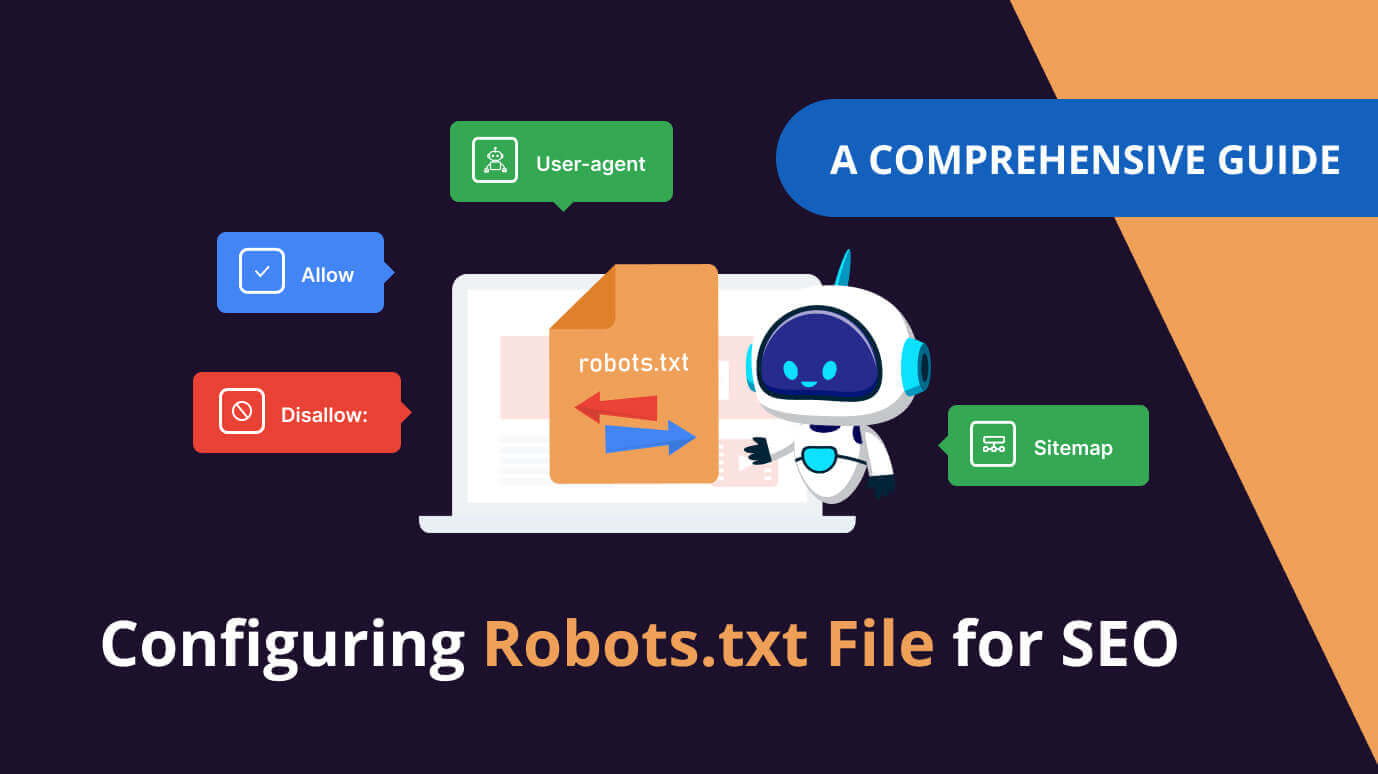

Giới thiệu về File robots.txt

Định nghĩa và vai trò của robots.txt

Trong thế giới kỹ thuật số ngày nay, việc quản lý cách các công cụ tìm kiếm tương tác với trang web của bạn là vô cùng quan trọng. Một trong những công cụ mạnh mẽ hỗ trợ bạn trong việc này chính là file robots.txt. Vậy file robots.txt là gì? Đây là một file văn bản đơn giản, được đặt ở thư mục gốc của website, có vai trò như một bản hướng dẫn cho các trình thu thập dữ liệu (crawlers) của các công cụ tìm kiếm, chẳng hạn như Googlebot của Google. Nó cho phép bạn kiểm soát những phần nào của website mà bạn muốn các bot này truy cập và lập chỉ mục, và những phần nào bạn muốn chúng bỏ qua.

Vai trò chính của file robots.txt là hướng dẫn các bot tìm kiếm. Thay vì để các bot tự do khám phá toàn bộ trang web, bạn có thể sử dụng file này để chỉ định rõ các khu vực cần được ưu tiên thu thập dữ liệu, cũng như các khu vực nên bị bỏ qua. Điều này giúp tối ưu hóa quá trình thu thập thông tin của các công cụ tìm kiếm, đảm bảo rằng những nội dung quan trọng nhất trên website của bạn được lập chỉ mục đầy đủ và chính xác, từ đó cải thiện thứ hạng trên kết quả tìm kiếm.

Lịch sử phát triển của robots.txt

File robots.txt không phải là một phát minh mới mẻ mà đã trải qua một quá trình phát triển đáng kể. Ý tưởng về việc cho phép các chủ sở hữu website kiểm soát quyền truy cập của các bot tìm kiếm bắt đầu từ những năm 1990, khi internet bắt đầu phát triển mạnh mẽ. Tuy nhiên, file robots.txt như chúng ta biết ngày nay được chính thức giới thiệu vào năm 1994 bởi Martijn Koster. Đây là một bước tiến quan trọng, đánh dấu sự ra đời của một tiêu chuẩn chung giúp các nhà quản trị web dễ dàng hơn trong việc quản lý hoạt động của các bot tìm kiếm.

Từ đó đến nay, file robots.txt đã trải qua nhiều cải tiến nhưng vẫn giữ nguyên cấu trúc cơ bản. Các công cụ tìm kiếm lớn như Google, Bing đều tuân thủ theo chuẩn này, tuy nhiên đôi khi có những ngoại lệ nhỏ trong cách diễn giải. Qua thời gian, các công cụ kiểm tra và xác thực file robots.txt cũng ra đời, giúp các nhà phát triển web dễ dàng kiểm tra và tối ưu hóa cấu hình file.

Tại sao Sử Dụng File robots.txt?

Kiểm soát truy cập của trình thu thập dữ liệu

Một trong những lý do quan trọng nhất để sử dụng file robots.txt là để kiểm soát cách các trình thu thập dữ liệu truy cập website của bạn. Nếu không có file này, các bot tìm kiếm sẽ tự do khám phá mọi ngóc ngách trên trang web, điều này đôi khi không phải là điều mong muốn. Bạn có thể sử dụng robots.txt để ngăn chặn việc thu thập dữ liệu các trang không quan trọng hoặc các trang chỉ dành cho mục đích nội bộ, giúp các công cụ tìm kiếm tập trung vào những phần nội dung có giá trị nhất.

Ví dụ, nếu bạn có một khu vực quản trị hoặc các trang chứa thông tin cá nhân của người dùng, bạn chắc chắn sẽ muốn chặn không cho các bot tìm kiếm truy cập vào các khu vực này. Bằng cách sử dụng các chỉ thị cụ thể trong file robots.txt, bạn có thể hướng dẫn các bot bỏ qua các trang hoặc thư mục không cần thiết, đồng thời cải thiện hiệu quả SEO bằng cách đảm bảo rằng các công cụ tìm kiếm tập trung vào nội dung chất lượng.

Bảo vệ thông tin nhạy cảm

Ngoài việc kiểm soát truy cập, file robots.txt còn đóng vai trò quan trọng trong việc bảo vệ thông tin nhạy cảm. Có những phần của website mà bạn không muốn hiển thị công khai trên kết quả tìm kiếm, ví dụ như các trang quản trị, các thư mục chứa tài liệu nội bộ, hoặc các tệp tin tạm thời. Việc sử dụng file robots.txt để chặn các bot truy cập vào các khu vực này là một biện pháp an ninh cơ bản nhưng rất hiệu quả.

Tuy nhiên, cần lưu ý rằng file robots.txt không phải là một giải pháp bảo mật hoàn hảo. Nó chỉ đơn thuần là một hướng dẫn, và các bot tìm kiếm không bắt buộc phải tuân theo. Vì vậy, việc bảo vệ thông tin nhạy cảm cũng cần kết hợp với các biện pháp bảo mật khác, chẳng hạn như xác thực người dùng và kiểm soát quyền truy cập. Mặc dù vậy, file robots.txt vẫn là một lớp phòng thủ quan trọng, giúp giảm thiểu rủi ro lộ thông tin do các bot tìm kiếm gây ra.

Cách Tạo và Cấu Hình File robots.txt

Các bước cơ bản để tạo file robots.txt

Việc tạo một file robots.txt khá đơn giản. Bạn có thể bắt đầu bằng cách mở một trình soạn thảo văn bản (ví dụ: Notepad trên Windows hoặc TextEdit trên macOS) và tạo một file mới. Lưu ý rằng, file này phải được đặt tên chính xác là robots.txt và không có bất kỳ phần mở rộng nào khác. Sau khi tạo file, bạn cần lưu nó vào thư mục gốc của website. Điều này có nghĩa là nếu địa chỉ website của bạn là www.example.com, thì file robots.txt phải được truy cập thông qua đường dẫn www.example.com/robots.txt. Nếu bạn không thấy file robots.txt thì có nghĩa là nó chưa được tạo hoặc đặt sai vị trí.

Trong file robots.txt, bạn sẽ viết các quy tắc hướng dẫn cho các bot tìm kiếm. Một file robots.txt cơ bản bao gồm các thành phần như User-agent để chỉ định loại bot tìm kiếm nào bạn đang nhắm đến (ví dụ: User-agent: Googlebot cho bot của Google) và Disallow để chỉ định các thư mục hoặc trang mà bạn không muốn các bot này truy cập (ví dụ: Disallow: /admin/ để chặn truy cập vào thư mục admin). Ngoài ra, bạn cũng có thể sử dụng Allow để chỉ định các trang mà bạn muốn các bot được phép truy cập. Hãy cẩn thận khi cấu hình file này, chỉ cần một lỗi nhỏ cũng có thể gây ảnh hưởng nghiêm trọng đến việc thu thập dữ liệu của các bot tìm kiếm trên trang của bạn.

[image title=”Hướng dẫn từng bước tạo file robots.txt” prompt=”Illustrate a comprehensive visual guide to creating a ‘robots.txt’ file on a computer for website management. Begin with an image showing a user accessing a text editor on their computer, clearly displaying the desktop environment. Progress through each step of the creation process: illustrating the typing of ‘User-agent’ and ‘Disallow’ directives in the editor, emphasizing proper syntax with color-coded text. Highlight crucial actions such as selecting “Save As,” opting for the “.txt” file format, and demonstrate correct placement in the server’s root directory, using visual cues like arrows or labels. Incorporate annotations to detail instructions, ensuring fonts are legible and colors are distinct for easy understanding of each phase in the procedure.”]

Cách viết hướng dẫn cho bot trong file

Việc viết hướng dẫn cho bot trong file robots.txt đòi hỏi bạn phải hiểu rõ cú pháp và các quy tắc. Như đã đề cập, User-agent được dùng để xác định bot nào sẽ áp dụng quy tắc, có thể là * để áp dụng cho tất cả các bot hoặc một bot cụ thể như Googlebot, Bingbot… Disallow là chỉ thị quan trọng nhất, cho phép bạn chặn các bot truy cập vào các trang hoặc thư mục cụ thể. Ví dụ, Disallow: /private/ sẽ ngăn chặn bot truy cập vào bất kỳ trang nào trong thư mục private.

Bạn cũng có thể sử dụng Allow để cho phép các bot truy cập vào một số trang cụ thể trong một thư mục mà bạn đã chặn, đây là một cách để bạn kiểm soát chi tiết hơn các bot truy cập. Ví dụ Disallow: /images/ sẽ chặn tất cả các file trong thư mục images nhưng Allow: /images/specific-image.jpg sẽ cho phép bot truy cập vào đúng file đó. Một số sai lầm thường gặp khi viết file robots.txt là sử dụng sai cú pháp, chẳng hạn như quên dấu / ở đầu các đường dẫn hoặc viết sai tên của User-agent. Hãy luôn cẩn thận và kiểm tra kỹ càng trước khi áp dụng các thay đổi.

Công cụ kiểm tra và xác thực file robots.txt

Sau khi tạo và cấu hình file robots.txt, việc kiểm tra và xác thực nó là rất quan trọng. Rất may mắn là có nhiều công cụ trực tuyến miễn phí có thể giúp bạn thực hiện việc này. Các công cụ này không chỉ giúp bạn kiểm tra xem cú pháp của file robots.txt có đúng hay không mà còn cho phép bạn xem các bot của các công cụ tìm kiếm sẽ đọc và hiểu file này như thế nào.

Một số công cụ phổ biến bạn có thể sử dụng bao gồm: Google Search Console (nếu bạn đã xác minh website của mình với Google), và nhiều công cụ kiểm tra robots.txt khác có sẵn trên internet. Các công cụ này thường cung cấp một giao diện trực quan, cho phép bạn sao chép và dán nội dung của file robots.txt vào để kiểm tra. Sau khi kiểm tra, chúng sẽ thông báo cho bạn về bất kỳ lỗi nào, và đưa ra gợi ý để khắc phục. Việc sử dụng thường xuyên các công cụ này sẽ giúp bạn đảm bảo rằng file robots.txt của bạn luôn hoạt động đúng và hiệu quả.

Công cụ kiểm tra file robots.txt trực tuyến

Những Lưu Ý Khi Sử Dụng File robots.txt

Các hạn chế của file robots.txt

Mặc dù file robots.txt rất hữu ích, nhưng bạn cũng cần phải hiểu rõ các hạn chế của nó. Như đã đề cập, file này chỉ là một hướng dẫn cho các bot tìm kiếm, chứ không phải là một luật lệ bắt buộc. Các bot tuân thủ theo tiêu chuẩn robots.txt thường là các bot của các công cụ tìm kiếm lớn như Google, Bing. Tuy nhiên, vẫn có một số bot không tuân thủ theo quy tắc này, đặc biệt là các bot thu thập thông tin cho mục đích xấu, vì vậy file này không thể được xem là một giải pháp bảo mật tuyệt đối. Ngoài ra, robots.txt chỉ có thể ngăn chặn các bot truy cập vào các trang, chứ không thể ngăn chặn người dùng truy cập vào các trang đó nếu họ biết đường dẫn trực tiếp.

Một hạn chế khác của file robots.txt là nó không thể ẩn hoàn toàn nội dung của bạn khỏi các công cụ tìm kiếm. Nếu một trang bị chặn trong robots.txt, nhưng vẫn được liên kết từ một trang khác đã được lập chỉ mục, các công cụ tìm kiếm vẫn có thể tìm thấy nó. Do đó, bạn nên kết hợp file robots.txt với các biện pháp bảo mật khác, chẳng hạn như yêu cầu xác thực người dùng hoặc sử dụng thẻ noindex trong HTML để ngăn chặn các công cụ tìm kiếm lập chỉ mục các trang nhất định.

Sai lầm phổ biến khi cấu hình

Có nhiều sai lầm phổ biến mà người dùng thường mắc phải khi cấu hình file robots.txt. Một trong số đó là chặn nhầm các trang quan trọng. Đôi khi, vì một vài lý do nào đó, người dùng chặn nhầm các trang mà họ muốn công cụ tìm kiếm thu thập thông tin, điều này gây ảnh hưởng đến SEO của website. Việc sử dụng sai cú pháp cũng là một lỗi thường gặp, ví dụ như quên dấu / ở đầu đường dẫn, hoặc sử dụng sai tên của bot. Một lỗi khác là cấu hình quá rộng, khi đó bạn có thể vô tình chặn một thư mục mà bạn không hề muốn, hoặc cấu hình quá chi tiết lại khiến cho file robots.txt trở nên cồng kềnh.

Để tránh các lỗi này, bạn nên kiểm tra kỹ cấu hình của file robots.txt trước khi áp dụng. Bạn có thể sử dụng các công cụ kiểm tra trực tuyến để xác nhận xem các quy tắc của bạn có đang hoạt động đúng hay không. Nếu có thể, hãy bắt đầu từ những quy tắc đơn giản, sau đó dần dần thêm vào các quy tắc phức tạp hơn. Việc nắm vững các kiến thức cơ bản và thực hành thường xuyên là chìa khóa để tránh những sai lầm không đáng có.

Sai lầm phổ biến khi cấu hình file robots.txt

Kết luận

File robots.txt là một công cụ mạnh mẽ và hữu ích cho việc quản lý cách các công cụ tìm kiếm tương tác với website của bạn. Nó giúp bạn kiểm soát truy cập, bảo vệ thông tin nhạy cảm và tối ưu hóa quá trình thu thập dữ liệu của các bot tìm kiếm. Tuy nhiên, bạn cần lưu ý rằng file robots.txt có những hạn chế và không phải là một giải pháp bảo mật tuyệt đối. Để sử dụng công cụ này một cách hiệu quả, bạn cần phải hiểu rõ cú pháp, các quy tắc và tránh những sai lầm phổ biến khi cấu hình. Bằng việc sử dụng robots.txt một cách thông minh và cẩn thận, bạn có thể đảm bảo rằng website của mình được thu thập dữ liệu và lập chỉ mục một cách tối ưu, từ đó cải thiện thứ hạng trên kết quả tìm kiếm và mang lại trải nghiệm tốt hơn cho người dùng.